更适合文本分类的轻量级预训练模型

自 BERT 起,预训练语言模型沿着海量训练数据和庞大 *** 结构的方向在不断发展着。在12月落幕的 NeurIPS 2020 会议上,语言模型 GPT-3 荣膺更佳论文奖。OpenAI 的研究人员使用了多达 45TB 的文本数据来训练它的 1750 亿个参数。GPT-3 不仅仅是“变得更大”,它用“Few-Shot”学习替代了 FineTune,能够出色完成代码生成、领域问答、吉他谱曲等高难度的复合型 NLP 任务。

那么,在相反的道路上,当数据受限并且算力不足,是否有轻量级的预训练模型能够帮助我们更好地处理文本分类等经典NLP问题呢?

AllenAI 团队开源的 VAMPIRE(Variational Methods for Pretraining In Resource-limited Environments)正是这样一款模型。全文《Variational Pretraining for Semi-supervised Text Classi?cation》收录于ACL-2019。

本文将详细介绍一种基于预训练半监督的文本分类轻量型模型,即 VAMPIRE 模型,为解决由于大量数据和高昂计算力导致的资源不足问题提供一些思路。

01变分自编码器

VAMPIRE 从 VAE 中借鉴了不少思路,在详细介绍它之前,先来说说什么是 Variational AutoEncoder(VAE),中文译作变分自编码器。VAE 出自 ICLR-2014 的 《Auto-Encoding Variational Bayes》,是一种图像生成技术,近年来也被迁移到 NLP 中作为一种文本生成模型。原文中有大段大段的公式推导,全部理解需要费不少功夫。不过对于 VAMPIRE 来说,重要的是弄明白 VAE 是建立在什么样的假设之上,它是通过什么样的方式来实现文本生成的。

和 encoder-decoder 架构一样,VAE 也是通过“编码”和“解码”来完成对输入句子的重建。两者的区别在于,发源于 CV 的 VAE 并不是一种天然有序的 NLP 模型。在理解 VAE 之前,需要先彻底抛下头脑中关于 Seq2Seq 那种 one by one 生成方式的固有印象。输入序列中的每个词可以是相关的,也可以互相独立的,这取决于你使用什么样的编码器。但是,输出序列中的每个词,一定是互不依赖的。它们被各自建模,同时生成。为了便于理解,我们暂且将重建任务看成是对单个词的建模。这一过程可以用更广义的分布-采样概念来描述:

○ 对于一个离散样本X,计算其概率分布,根据分布表达式进行采样,生成新的离散样本 X'。令 X' 无限逼近 X。

如果用 encoder-decoder 的术语来说,“计算概率分布”即“编码”,“分布表达式”即隐 层,“采样生成”即“解码”。这里有一个难点。X 是个离散变量,它很有可能服从某个奇奇怪怪的 分布,根本就写不出具体的表达式,更别提根据表达式来采样了。因此,VAE 以正态分布作为搭桥, 先将 X 变换到正态分布 N(X) 上,再根据公式进行采样得到 Z,对 Z 进行变换生成 X'。至于 X -> N(X) 和 Z -> X',就直接扔进神经 *** 学出来。一个特定的正态分布,只由均值和方差决定。因此, X -> N(X) 的变换,实际使用了两个神经 *** ,分别估算均值 u 和方差 sigma。

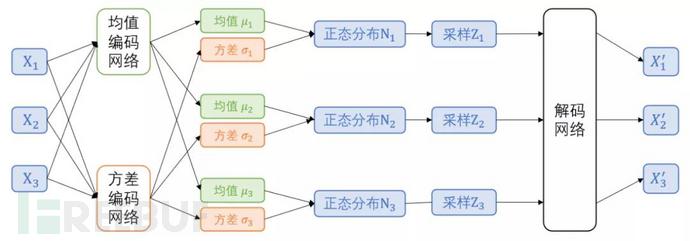

以上是对于单个词的建模。当输入的是 n 个词组成的句子时,在每个词位置都需要进行上述处理。也就是说,有 n 组正态分布,对应着 n 组均值和 n 组方差。好了,现在可以画出整个前向计算的流程图了:

在前向计算过程中,每个 X 都是 embedding 向量,经编码产生的均值和方差也同样是向量(假设维 度为dim)。那么,实际上生成了 dim 个正态分布,它们各自独立采样,组成维度为 dim 向量 Z。从 Pytorch 示例代码中可以更直观地看到数据流向:

VAE 的优化目标分为两部分。之一部分是重建目标,即 X'=X:

在不加入额外约束项时,模型可以很轻松地做到 100% 地还原 X,只要让方差全部为 0,均值取原值即可。显然,这样的模型是不具备真正生成能力的。因此,VAE 的优化目标还包含第二部分,使用 KL 散度把 Z(X) 拉向标准正太分布N(0, I)。可以理解为正则化项,或是对生成 *** 加噪。

两个 loss 互相对抗,同步学习优化。

02 VAMPIRE

现在可以正式介绍 VAMPIRE 了。这是一个为算力和数据双双受限的情况设计的轻量预训练模型,它的典型应用场景是半监督文本分类。VAMPIRE 在本质上是一个文档话题模型,它从一开始就抛弃了序列信息,将句子当作 BOW(Bag of Words)进行建模。模型捕捉的是词与词的共现信息,重建的是词频向量。这样的设计使得无论是模型训练还是预测推理都大大加快。

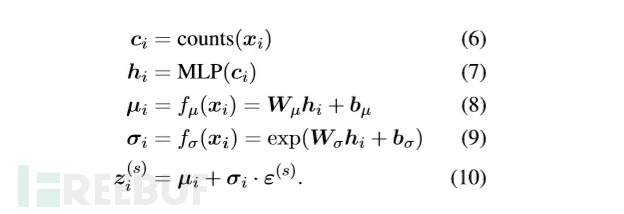

对于输入句子 X,VAMPIRE 统计词表中每个词的频次,构建词频向量作为句子表示。编码器部分是和 VAE 一样的均值方差预测,然后进行重参数采样:

解码器部分做了适配改造,先对采样变量 Z 做一次 softmax 得到 theta,作者将其解释为对隐话题的分布计算。其中,公式13 即重建目标 loss1。

在完成预训练后,theta 被记为 vampire embedding,参与下游任务。和 Bert 等模型不同的是, vampire embedding 作为辅助话题信息,并不能单独完成编码训练。它需要和 word embedding 融合在一起,共同进行分类预测:

03 应用场景

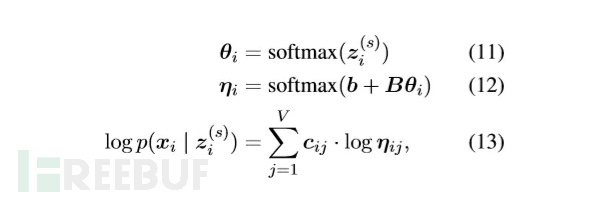

在低资源场景下,当算力受限并且也没有可观的领域数据时,VAMPIRE 等轻量级的预训练模型也可以作为一种备选方案。作者在 AG News、Hatespeech、IMDB 和 Yahoo! 四个任务上,测试了 VAMPIRE 与基线词向量模型在标注数据量从 200~10000 范围内的分类准确度。从图上可以明显地观察到,在标注数据不足 2000 条时,VAMPIRE 模型的表现较基线有大幅度的提升。

04总结

ELMO、BERT 和 GPT 等预训练模型的出现,彻底革新了半监督 NLP 的研究。在海量无标注数据上训练的文本向量表示,不仅能够显著提升下游任务的性能,而且这种助力不局限于单一的任务类型。

相关文章

办结婚证需要什么材料,办理流程是怎么样!

新人结婚的第一件事就是去办结婚证了,这不仅是两人爱情的证明,也是婚姻的保护伞,那么2018年办结婚证需要什么材料?下面跟着小编一起来看看吧! 1、两人户口簿和居民身份证。 2、两人无配偶。...

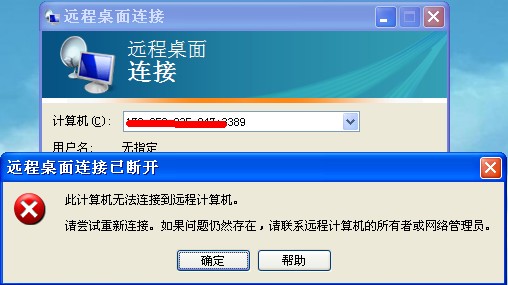

对于提权成功后3389连不上的几种解决办法

有时候我们入侵提完权后,3389端口开了,可还是没办法连3389,这是非常蛋疼的一件事。连不上通常用以下几种可能以及对应的解决办法。 提供一些思路和方法。 方法一:网站服务器在内网。...

win10解除飞行模式锁定

最近有网民在应用win10系统软件时很想要win10消除手机飞行模式锁住,要想用手机飞行模式,可是客户并不了解怎么操作,因此十分苦恼。实际上解决方法挺简易的,下边我和大伙儿共享下有关win10消除手机...

博客怎么赚钱?个人博客怎么盈利

个人博客怎么赚钱,如何做到月收入1万+我想这是每个博客人员都比较常聊的问题,这其中有一部分人想通过博客赚钱但是自己不会搭建博客(没关系乐建可以教你)其次一部分人是有博客但不知道如何运营推广,那么今天...

这张磁盘有写保护无法格式化怎么办

有很多盆友碰到那样的状况,U盘在不知道缘故的状况就不可以往里写文档,乃至连读写能力都不成功的状况,一直提醒“这张硬盘有写保护”,也不可以恢复出厂设置。如今我就和大伙儿共享这张硬盘有写保护无法格式化...

美丽的小路(美丽的小路课件)

说起电子白板交互,并不象大家想的那样神秘,它只是把PPT的演示变为学生的动手操作。把课件由封闭性变为开放性。白板打破了以往课堂被已制作成的PPT牵着。 一、背景材料课文讲述了一个有关环境卫生的故事。它...

免责声明:本站所发布的任何网站,全部来源于互联网,版权争议与本站无关。仅供技术交流,如有侵权或不合适,请联系本人进行删除。不允许做任何非法用途!

免责声明:本站所发布的任何网站,全部来源于互联网,版权争议与本站无关。仅供技术交流,如有侵权或不合适,请联系本人进行删除。不允许做任何非法用途!