robots文件的认知及了解robots文件的基本写法使用规则

robots文件一般在根目录下,每一条记录通过空行分开,在该文件中可以使用#进行注释,支持模糊匹配,该文件是区分大小写的但不严格,通常以一行或多行User-agent开始,后面加上若干Disallow和Allow。

Disallow:该项的值用于描述不希望被访问的一组URL,这个值可以是一条完整的路径,也可以是路径的非空前缀。Allow:该项的值用于描述希望被访问的一组URL,这个值可以是一条完整的路径,也可以是路径的前缀。

值得提醒的是每个搜索引擎都协议文件的解读不一样,比如百度是支持”*”和”$”来模糊匹配url的。”*”匹配0或多个任意字符,”$”匹配行结束符。最重要的是这个语法是从上到下生效的,切记。

常见的用法在网上可以找到,这里就这儿工具说几个不常见的,但是有用的东西,你们可以举一反三。

屏蔽所jpg或png图片被抓取:Disallow:/*.jpg$ 或者Disallow:/*.png$

禁止抓取所有动态页面:

User-agent:*

Disallow:/*?*

只允许抓取html网页:

Allow:/*.html$

User-agent:*

Disallow:/

禁止抓取后台所有文件同时隐藏后台真实目录:

#就这儿注释:比如你后台目录名是htdoadmin

Disallow:/*doad*

同时这个文件也支持放入网站地图地址:

#就这儿工具注释:一般放在整体结尾

Sitemap: http://XXX.com/sitemap.xml

最后面填个坑吧:上面说这个文件语法是从上到下生效,你或者不明白。就这儿在此举例说明:

#就这儿工具注释:仅允许 Baiduspider访问您的网站

User-agent: Baiduspider

Allow:/

User-agent:*

Disallow:/

前2行允许了百度爬行,那么第3-4行即使屏蔽了所有引擎包括百度,依然是允许百度爬行的。你明白了吗?再补充一个例子吧:

User-agent:*

Allow:/nihao/qincai

Disallow:/nihao/

这个写法将会阻止爬行:http://baidu.com/nihao/abc或者http://baidu.com/nihao/

但不会阻止爬行:http://baidu.com/nihao/qincai123或者http://baidu.com/nihao/qincai/123

文章结尾问你一个问题,你可以迅速回答出来吗?请问robots.txt里出现disallow是对的吗?

相关文章

黑道小说排名?黑道十大巅峰网络小说

社会不只是眼前的光鲜亮丽,在这些光鲜亮丽的背后,也有游走于法律边缘的黑色地带,而这些我们在生活中也不一定能接触到!可有阳光的地方也有黑暗,今天就给大家介绍几本写实的黑道类小说,带大家接触一下那些关于黑...

3dgirlz2黑客的简单介绍

本文目录一览: 1、我这配置能玩什么游戏 2、求2个单机游戏 3、求些单机游戏 4、推荐2G以下的第一人称单机游戏 5、红色警戒2尤里的复仇游戏下载 6、单机游戏 我这配置能玩什...

黑客炫酷图片,找黑客帮忙网,黑客一般怎么找的

11过错10回来正常页面 有针对性的运用:这个JavaScript歹意代码宗族以及 iframe注入针对的是特别装备条件,地理位置,以及IP散布状况。 这种歹意脚本和服务器在进犯IE阅读器用户的时分...

怎么让狗狗适应狗笼(狗笼如何选择)

你的狗狗必须在屋内有属于自己的地盘。实现方法之一是给它一个笼子。笼内训练既能保护幼犬免受伤害,也能让家里的物品不致遭殃,还有助于如厕训练。不过,你绝不能以笼子作为惩罚工具。 【狗笼的选择】 根...

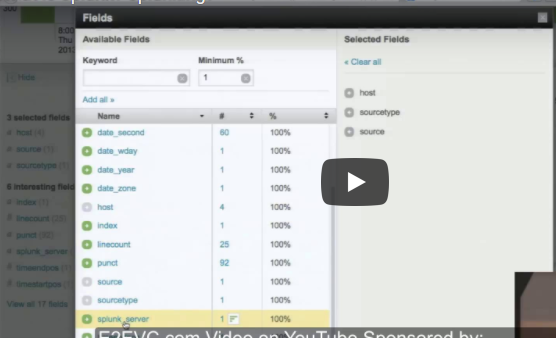

Splunk是不是适用全部电脑操作系统?

什么叫Splunk? Splunk捕捉,数据库索引,随后关系可检索的储存库文件的数据信息,从这当中能够 转化成汇报,图型,报警,数据可视化和汽车仪表板。被觉得是最好是的安全工器具之一,这个东西的纯碎...

和平精英一周年精英玩家称号领取地址

和平精英一周年精英玩家称号领取地址 手机QQ或微信扫码->进入活动页面->点跳过->领取即可 活动地址:https://gp.qq.com/act/2688/a202...

免责声明:本站所发布的任何网站,全部来源于互联网,版权争议与本站无关。仅供技术交流,如有侵权或不合适,请联系本人进行删除。不允许做任何非法用途!

免责声明:本站所发布的任何网站,全部来源于互联网,版权争议与本站无关。仅供技术交流,如有侵权或不合适,请联系本人进行删除。不允许做任何非法用途!