如何与恶意“蜘蛛”暗度陈仓?

在搜索引擎优化的进程中,您是否碰着过这样的问题:处事器会见的CPU操作率险些是100%,页面加载速度很是慢,看起来像是受到了DDOS的进攻。

颠末一番查抄,发明本来的方针网站常常被大量不相关的“爬虫”抓取。对付一个小网站来说,这大概是一场劫难。

因此,当我们举办网站优化时,我们需要对特定的蜘蛛有选择性的指导。

按照以往的搜索引擎优化履历分享,陈子将通过以下内容举办叙述:

1。搜索引擎爬虫

至于我们海内的相助同伴,我们都知道在搜索引擎优化的进程中,我们面临的最常见的爬虫是搜索引擎的爬虫,好比百度蜘蛛,同时,我们也谋面临各类搜索引擎的蜘蛛。譬喻:

①360Spider,SogouSpider,Bytespider

②Googlebot,Bingbot,Slurp,Teoma,ia_archiver,twiceler,MSNBot

③其他crawlers

假如你不决心设置你的robots.txt文件,理论上,你的方针页面可以被爬行和爬行,但对付一些中小型网站,它偶然会严重挥霍它的处事器资源。

在这个时候,我们需要做出有选择性和公道的引导,尤其是对付一些难过的问题,好比:你想让谷歌淘汰在网站上的抓取而不完全屏蔽它,你大概需要一些小能力,好比:为特定的爬虫会见反馈差异的文章列表:

①列表节制更新频率

②反馈大量反复。内容农场的网页

③善意“蜘蛛陷阱”如:Flash

④对方SEO如何打点平台,可以适当调解抓取的评论和调解

等。尽量这种计策大概会对页面的声誉造成损害,但对付那些不想频繁爬行但需要不绝爬行的蜘蛛来说,这是一种相对“有效”的要领。

2。链接阐明爬虫

以后刻开始,一个搜索引擎优化外部链接阐明打点东西需要耗费大量的处事器资源来抓取整个 *** ,而且天天检测每个网站的页面链接。

对付一些资源麋集型网站,它们一天大概会爬行数万次。这种爬虫很常见。

假如你不想让你本身的网站参加个中,最简朴的计策就是将这些爬虫完全包括在呆板人协议中。

3。内容收集爬虫

可是当我们面临一些恶意的内容收集爬虫时,相对难过的是对方常常采纳一种“隐形”的状态,好比:仿照一个著名的搜索引擎蜘蛛的名字。

对付这样的问题,我们只妙手动判定来检讨对方庐山的真伪,好比,用IP泛判别率呼吁来判定是真是假。

① linux平台: hostip

②鳏夫平台: nslookup ip

判定对方的理会地点是否为相应的搜索引擎域名。

4。蜘蛛池爬虫

今朝,市场上有许多人在做百度蜘蛛池。它的主要目标是辅佐更多的页面做百度的快速收集,但由于一些随机下载的蜘蛛池的非尺度编程。

未能正确地爬行和限制差异的蜘蛛凡是会导致大量处事器资源被占用,这使得处事提供商很容易封锁处事器。

假如你试图用这个计策来提高你的页面包围率,那么你大概需要多加留意。(但我们不推荐它)

如何与恶意“蜘蛛”暗度陈仓?第总结条:搜索引擎优化是一项细致的事情,每一个计策城市影响整个站点的运行状态。以上内容仅为扼要阐明,合用于中小型站长,仅供参考!

相关文章

解决百度推广恶意点击以及反攻击的方法!

最近很多朋友和我说起来关于网站百度推广被恶意点击的事情,对于这个事情很多老板会觉得很尴尬,这种点击几乎像寄生虫一样,又没办法完全的消除,最多也就是得到控制,其实对于类似的解决方案我这边也有,现在给大家...

怎么同时接收老公微信 怎么偷偷同步老婆微信

据 ZDNet 报道,恶意软件制作者正在滥用 Firefox 的一个漏洞来诱骗用户。耐人寻味的是,该漏洞最早于2007年4月被反馈,且后续也有多次被反馈,却不知出于什么原因,迟迟未被修复。...

黑客教你3分钟盗快手号  [网络安全自学篇

这是作者的系列网络安全自学教程,主要是关于网安工具和实践操作的在线笔记,特分享出来与博友共勉,希望您们喜欢,一起进步。前文分享了Web渗透的第一步工作,涉及网站信息、域名信息、端口信息、敏感信息及指纹...

以打假之名实行敲诈?恶意投诉牟利下月起将受限

以“打假”之名,通过恶意投诉而牟利的行为将从下月起受限。2020年1月1日,国家市场监督管理总局新发布的《市场监督管理投诉举报处理暂行办法》(以下简称《暂行办法》)将正式实施,其中明确规定“不是为生活...

黑客教你盗快手  [网络安全自学篇

这是作者的系列网络安全自学教程,主要是关于网安工具和实践操作的在线笔记,特分享出来与博友共勉,希望您们喜欢,一起进步。前文分享了Web渗透的第一步工作,涉及网站信息、域名信息、端口信息、敏感信息及指纹...

防恶意点击系统软件有用吗(防恶意点击系统哪家好)

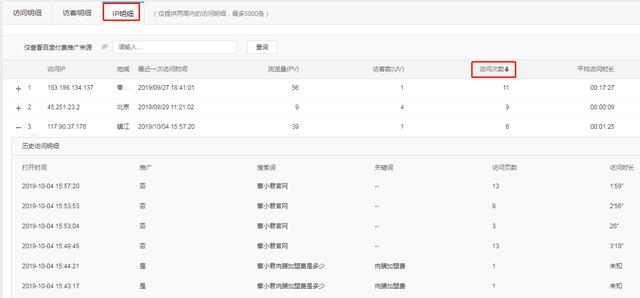

1、安装统计工具便于分析数据 我们可以根据百度统计后台的实时访客下面的ip明细,按访问次数排列,把访问次数超过5次(竞价一般都是新客)的ip进行屏蔽。 建议按周统计查询到的恶意点击IP,记录到一个e...

免责声明:本站所发布的任何网站,全部来源于互联网,版权争议与本站无关。仅供技术交流,如有侵权或不合适,请联系本人进行删除。不允许做任何非法用途!

免责声明:本站所发布的任何网站,全部来源于互联网,版权争议与本站无关。仅供技术交流,如有侵权或不合适,请联系本人进行删除。不允许做任何非法用途!