通过ZAT结合机器学习进行威胁检测(三)

系列文章

通过ZAT结合机器学习进行威胁检测

通过ZAT结合机器学习进行威胁检测(二)

从zeek日志到Parquet

首先我这里简单介绍一下parquet。Parquet出现的目的是使Hadoop生态系统中的任何项目都可以利用压缩,高效的列式数据,是Hadoop生态系统中任何项目均可使用的列式存储格式。

软件

Zeek分析工具(ZAT)

parquet

spark

数据

zeek中大约 2300万行的数据集

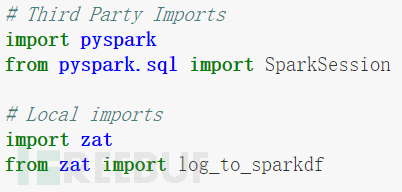

导入所需要的库

使用4个并行执行器启动Spark

在这里,我们使用4个并行执行器来构建本地Spark服务器。我这边是在MAC上运行,对于spark服务器我建议采用至少8核的服务器。以下代码启动4个执行程序并加载conn.log数据到spark

Spark Worker和数据分区

Spark将读入并将数据分区给我们的工作人员。我们的dataframe(rdd) *** 将具有一些在工作池中划分的分区。每个工作人员将仅对一部分数据进行操作如下所示

spark_df.rdd.getNumPartitions()

spark_df.rdd.getNumPartitions()

将我的Zeek日志转换为Parquet文件

Apache Parquet是一种专注于性能的列式存储格式。这是我们将Zeek / Zeek日志转换为Parquet文件的代码,只需一行代码。由于我们使用Spark分布式执行程序进行转换,因此该转换具有超级可伸缩性。

Parquet files are compressed

在这里我们可以看到parquet以压缩列格式存储数据,有几种压缩选型可以选择

原始conn.log数据达到了2个G

经过parquet后约420MB左右

现在我们将parquet的数据加载到了spark,我们演示了一些简单的spark的操作

首先获取有关spark dataframe的数据

Number of Rows: 22694356 Columns: ts,uid,id_orig_h,id_orig_p,id_resp_h,id_resp_p,proto,service,duration,orig_bytes,resp_bytes,conn_state,local_orig,missed_bytes,history,orig_pkts,orig_ip_bytes,resp_pkts,resp_ip_bytes,tunnel_parents

下面的查询是对4个执行程序的。数据包含超过2200万个zeek conn日志条目,完成时间仅仅是mac电脑上运行的一秒钟时间

让我们看一下各个主机,按端口和服务分组

总结

Spark具有强大的SQL引擎以及机器学习库。现在,我们已经将数据加载到Spark Dataframe中,下一章我们将利用Spark SQL命令使用Spark MLLib进行一些分析和聚类

相关文章

我想开网店怎么开?2019年开网店还赚钱吗

很多人都会问,2018开淘宝赚钱为时已晚吗? 我想说的是,有能力、有耐心的人在任何时候都可以做得很好,没有能力的人即使倒退十年,也不能开淘宝店。即使在过去几年里,不是每个淘宝店都能赚钱,赚钱的人往往...

免费查酒店的入住记录,什么软件可以查宾馆住宿记录

自己无法查询,需要去公安局。...

黑客接单qiushittk_找黑客窃取电脑资料

5. 修正 Peach 的版别无在曩昔的几年里,当局现已开端在冲击暗网中的网络违法活动了,其间包含优待儿童、违禁药品买卖、兵器出售、数据出售、勒索软件和黑客论坛等等。 近年来,大型网络违法商场逐步式微...

白话告诉你KOL、MCN、私域流量等是什么

白话告诉你KOL、MCN、私域流量等是什么及举例! 火爆互联网名词列表:(顺序从久到近) 新媒体、自媒体、粉丝经济、鱼塘、大数据、互联网+、互联网思维、互联网下半场、共享经济、长尾理论、IP、流量...

手机定位黑客联系方式(怎么样才能找到黑客的联系方式)

一、手机定位黑客联系方式(怎么样才能找到黑客的联系方式)方法总结 1、附近黑客的电话号码你在什么地方,应该离我很远吧! 2、黑客定位怎么和你联系呀一般只能知道你的ip地址信息,根据ip来定位,或者从...

开一个宾馆需要办理什么证件(开酒店需要办理的手续大全)

创业已经成为当下生活中年轻人群所热衷的趋势,因为一方面他们不愿意去遵守上班的按时按点,另外一方面创业的收入比一般上班要高很多。但是真正成为一名创业者之后,就会知道创业是多么不容易,而开酒店是很...

免责声明:本站所发布的任何网站,全部来源于互联网,版权争议与本站无关。仅供技术交流,如有侵权或不合适,请联系本人进行删除。不允许做任何非法用途!

免责声明:本站所发布的任何网站,全部来源于互联网,版权争议与本站无关。仅供技术交流,如有侵权或不合适,请联系本人进行删除。不允许做任何非法用途!